Problemes de rendiment OpenFiler amb VMWare Server [solucionat]

Després de molts mesos amb un greu problema de rendiment al servidor SAN/NAS de casa que tinc montat en una màqina virtual d’VMWare Server sobre Ubuntu 8.04 LTS, per fi m’he decidit a arreglar el problema. En algún altre post havia comentat el problema, la qüestió és que el rendiment dels 1.5Tb que tinc al servidor des del sistema operatiu de Host és d’uns 70MB/s però les mateixes proves des dels discos gestionats per la màquina Guest, o sigui l’OpenFiler, donaven uns patetis 3, 4 o com a molt 5MB/s. O sigui, que quan s’accedia per NFS o SMB als recursos compartits el rendiment era insuficient i d’altres servidors o màquines que usen aquests recursos se’n veien repercutits.

Finalment després de buscar una mica vaig veure que el problema venia de les interrupcions del sistema que es perdien degut a que el clock rate del servidor Host no era capaç de processar tantes interrupcions. Així doncs, investigant sobre el tema vaig veure que el que cal fer és donar suport HPET, en el meu cas perquè això funcioni ho he hagut d’activar també a la BIOS del HP ML110 que uso com a servidor físic. Amb aquests canvis els tests de velocitat de la màquina virtual amb OpenFiler m’han millorat substancialment i ara mateix donen resultats al voltant de 50MB/s. Obviament, encara estic lluny d’un rendiment òptim però ja no sé si això és tema de configuració o si el problema és més profund i ja depèn de la propia gestió interna que fa l’VMWare amb els mòduls que fan d’interficies entre el hardware real i el virtual.

Si voleu saber si teniu el HPET activat o no al kernel és tan senzill com mirar al dmesg:

root@vm0:~# dmesg |grep hpe

[ 120.210408] hpet clockevent registered

[ 120.210412] hpet0: at MMIO 0xfed00000, IRQs 2, 8, 0

[ 120.210416] hpet0: 3 64-bit timers, 14318180 HzEn cas de no tenir-lo activat, cal que activeu el següent al fitxer .config del kernel:

CONFIG_HPET_TIMER=y

CONFIG_HPET_EMULATE_RTC=y

CONFIG_RTC=y

A part d’això hi ha d’altres opcions per tal d’acotar aquest tipus de problemes, algunes que permeten estabilitzar les màquines virtuals malgrat no les expremem al màxim ens poden permetre funcionar millor si el rendiment no és el màxim dels nostres problemes i no saturem el Host. Per exemple, es pot afegir al fitxer .vmx de la màquina virtual la següent opció:

host.useFastClock = FALSE

Per cert, si voleu identificar el problema el kernel de la màquina Host dona errors de l’estil:

Aug 21 12:56:11 dey kernel: rtc: lost some interrupts at 2048Hz.

o també coses així:

select() to /dev/rtc to wait for clock tick timed out.

Com sempre a google podeu trobar moltíssima informació de com ajustar el vostre Linux perquè rendeixi al màxim amb VMWare. Per la meva part, ara hem queda posar en marxa mil i una coses que depenien d’aquest servidor de fitxers que mica en mica anava obligant-me a parar serveis per manca de rendiment. Espero que properament ja pugui posar en marxa funcions com l’album de fotografies i d’altres similars.

digital signage, en un cop d’ull

A moltes persones els costa entendre a quin mercat esta orientat movilpoint, doncs bé, aquest setembre i per primer cop a aquest país es farà una fira a Madrid sobre Digital Signage, mercat en el qual treballa l’empresa on treballo com CTO. Doncs bé, a la web de la fira: www.total-media.es he trobat el video que penjo a continuació i que explica diria jo que molt bé de què tracta el mercat del digital signage.

No oblideu el motto de movilpoint: kiosks and digital signage technologies

Hotel Balneario Vilas del Turbón

Avui he arribat de les mini-vacances per no parlar d’un cap de setmana llarg. De fet, qui no esta content és perquè no vol. La qüestió és que divendres hem vaig agafar el dia de festa i Estefania i jo varem sortir disparats com coets cap al Hotel Balneario Vilas del Turbón. Aquest lloc perdut de la mà de deu a terres d’Osca el varem coneixer no fa ni dues setmanes gràcies a que el Xavi i la Sabina i varen ser amb uns amics. Doncs bé, com a nota li posariem un cinquillo no massa més tot i que si fem una relació qualitat preu potser hauriem de pujar a un sis o un set. Ja que realment per ser temporada alta i per totes les terapies que ens han fet el preu era més que reaonable. Potser on la cosa coixejava una mica és en la qualitat dels mateixo però no pas pels recurso materials o per le instal·lacions en si mateixes sinó per la qualitat del personal. Potser és que jo sóc molt exigent ja que com diu la Neus a mi m’han fet tractaments i massatges a molts països diferents, de fet, té raó i això li he d’agraïr a la Daphne. De fet, un gran secret a crits és que sempre he volgut montar una blog sobre aquesta temàtica, o sigui, massatges balnearis i d’altres similars.

Tornant a Vilas del Turbón, de fet, el nom bé d’un petit poble de 38 habitants en el que trobem el balneari. El lloc sense cap luxe però molt net, pulit i acollidor disposa d’una gastronomia casolana que et deixa sempre satisfet i malgrat ser molt estrictes amb els horaris les taules i les formes de demanar el que menjarem al dia següent no tinc cap queixa del servei al contrari. Pel que fa a les terapies doncs el que ja deia abans, les instal·lacions estan molt bé… lluny dels gran hotels de luxe orientas o americans on he anat algunes vegades però malgrat això tot és molt nou i xulo a la part del Balneari. Llàsitma que el personal no disposava de l’experiència i l’energia necessaris per fer-nos disfrutar del paquet de tractaments que varem contractar. Tot i amb això varem saber treure-li el suc al tema.

Per concloure el resum, comentar com a cosa positiva que el lloc esta molt aïllat i per tant, no hi ha cobertura. Requisit indispensable per una bona desconnexió de món. L’entorn és genial i es troba a 1.500m d’altura aproximadament, o sigui, que de calor ben poca malgrat he vingut ben vermell de prendre el solet. Però això és un luxe que només pots prendret en les hores centrals del dia després fa una fresqueta molt agradable i més si tenim en compte que estem al mes d’agost. Des de Torelavit (el meu poble) el lloc es troba a unes dues hores llargues de camí, així doncs, en bona companyia i bona música no es fa llarg arribar-hi. Perquè ús en feu una idea es troba a l’altura de la Pobla de Segur, però a la zona aragonesa. Si no recordo malament la zona rep el nom del riu més famós que passa per allà: Ribagorzana. Concretament entre Benasque i Benabarre.

Huawei E960: router HSDPA de Vodafone

Aquesta tarda he estat provant el Huawei E960 de Voafone, després de l’experiència llarga i dur amb els Linksys WRT54G3G avui tocava descobrir el nou producte de Vodafone. Doncs bé, dir que venint dels Linksys que tants i tants problemes m’han donat, penseu que en tenim ara mateix instal·lats més de 200 i s’espera tenir-ne molts més en els propers mesos i la cosa esta lluny de funcionar bé. Per un costat els problemes de cobertura de l’operadora sobre els que no s’hi poden fer res i per l’altre el fet de que les targetes PCMCIA no acaben de funcionar massa bé ni soles ni amb el router Linksys com a host.

Aquesta tarda he estat provant el Huawei E960 de Voafone, després de l’experiència llarga i dur amb els Linksys WRT54G3G avui tocava descobrir el nou producte de Vodafone. Doncs bé, dir que venint dels Linksys que tants i tants problemes m’han donat, penseu que en tenim ara mateix instal·lats més de 200 i s’espera tenir-ne molts més en els propers mesos i la cosa esta lluny de funcionar bé. Per un costat els problemes de cobertura de l’operadora sobre els que no s’hi poden fer res i per l’altre el fet de que les targetes PCMCIA no acaben de funcionar massa bé ni soles ni amb el router Linksys com a host.

Els problemes típics han estat connexions que el router no informava correctament amb els leds, problemes de bloqueix de SIM per excés de reintents després de que la configuració es guardés malament, molts problemes d’accés a l’interficie web per la configuració i moltes connexions en falç fetes pel propi router. O sigui, connexions no demanades, connexions demanades i no detectades, etc. Per no parlar de la pobre configuració del linux que porta el Linksys dintre que fan que el rendiment del petit switch que incorpora l’aparell funcioni prou malament amb d’altres linux connectats a ell.

Bé doncs, al que toca. El nou router de Vodafone no és pas la ‘panacea‘ ni la solució a tots els malts de caps, però de moment sembla molt més estable i el que ja salta a la vista és que aquest mateix article l’estic escribint connectat des de casa meva a 2.6Mbps que malgrat estar lluny de ser reals donen un bon servei. Així doncs, això pot ser una gran notícia per alguns torrelavidencs que no disposen d’ADSL per manca de qualitat en les seves línies.

Pros a favor del modem/router:

- Pots connectar-hi un telèfon analògic i usar el router per trucar com si es tractés d’un fix

- 4 ports ethernet, que sembla que funcionen millor que en el Linksys

- CD d’instal·lació com a dispositiu Mass Storage USB dins el propi router

- Alimentació amb connector USB tipus B, via port USB o via transformador

- Suporta molts mètodes d’autenticació wi-fi, lluny de ser professional però destaca el suport d’WPA2

- Molt compacte

- No usa PCMCIA, per tant, disposa d’un compartiment especial per la SIM

- Sembla estable, de moment

- Bones orelles, o sigui, deu tenir una bona antena per aconseguir treure connexions HDSPA des del meu poble

- Fàcil usar-lo en mode DMZ o redirigit conta un servidor/firewall

Contres:

- No hem funciona com a modem USB a la primera al connectar-lo a un WinXP amb SP2, no he intentat arreglar el problema

- Interficie web de configuració molt pobre i lletja, malgrat això sembla que funciona ràpid i bé

- Firewall intern molt lamentable, lleig i limitat. Poc intuitiu el tema del NAT

- No suporta DynDNS (o similars), el Linksys si que ho suportava

En poques paraules aquest és el meu anàlisis del dispositiu. Com ja deia no és per tirar coets però sembla que algo de millora si que és sobre el Linksys.

UPDATE: ahir estava una mica espès i no se’m va acudir enganxar el test de velocitat que vaig fer amb el dispositiu, aquí teniu el test fet des de casa meva al mig de la muntanya 😉

podcast 1×12: mail-gateway (GatV2)

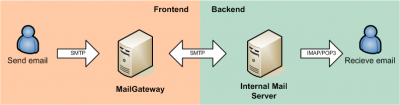

GatV2 es un servidor de correo para hacer smart-relay o para que se entienda mejor el concepto para usar como frontend del servidor de correo de la empresa o del ISP (backend). GatV2 nos filtra todo el correo UCE y nos ofrece una herramienta de gestión del SPAM.

El siguiente esquema ofrece una idea de donde estaría el GatV2:

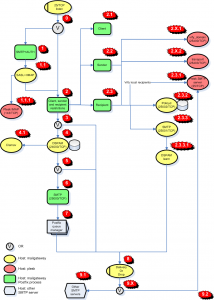

A través del podcast podreis seguir cual es el proceso que sigue un correo para pasar através del GatV2. Obviamente no es sencillo entender a la primera todo lo que hace pero a través de este gráfico (pinchar encima para zoom), de la explicación y de la documentación de la web del proyecto espero que podais comprender mejor el proceso.

Para ver las capturas de pantalla a las que se habla durante el podcast pasarós por la documentación del proyeco GatV2.

Finalmente el podcast:

[display_podcast]

El podcast dur alrededor de 1h, así pues Jorge me ha ayudado a hacer una tabla de contenidos del mismo así pues, podeis ir directamente al minuto que os interesa del podcast gracias a la siguiente información:

- Presentación: 0-1m44s

- Historia: 1m44s – 3m

- En que consiste: 3m – 8m15s

- Los componentes: 8m15s – 24m20s

- Como funciona: 24m20s – 42m49s

- WebUI del DSPAM: 42m49 – 55m55s

- Despedida y cierre: 55m55s – 56m56s

En los próximos dias publicaremos (Jorge y yo) el podcast dividido en pequeños MP3 en l página del proyecto GatV2 para mayor comodidad de los interesados en el proyecto.

Avui el blog compleix 8 anys!!!

Tal dia com avui a la bonica vila de Vinaròs (Castelló) vaig començar a escriure el meu blog, tranquils no tornaré a explicar la història que he explicat mil vegades sobre els inicis del mateix. Això si referenciaré el podcast 1×01 on explico els inicis del mateix per si algú encara no ho sap. Per altre banda, fa uns mesos no recordo qui hem va comentar la possibilitat de fer una gran festa per celebrar el 10è aniversari del blog i crec que agafaré la idea i des de ja començaré a pensar alguna forma ben original, i com sempre ben acompanyat dels mussols, per celebrar aquest fet tan insòlit. No tothom té la paciència d’aguantar tan de temps online 😉

Bé doncs aprofito aquest post que no ve a dir res d’interessant més enllà de l’efemèride per posar-vos una mica al dia de la meva vida i del perquè aquest mes he postejat tan poc, a més d’engaxar unes quantes fotos que tenia perdudes pel mòbil i que sota el meu punt de vista són dignes de comentar.

El primer i principal motiu del meu silenci és el que ja explico al podcast 1×11 i a l’article del ‘desafio networking‘, o sigui, el problema amb el ditxós dispositiu que m’ha portat pel camí de l’amargura alguns mesos fins que la situació ha estat insostenible i m’he hagut de buscar la vida buscant una solució urgent abans el mal no fos major. La resta de motius són de caire més personal, així doncs aprofito per comentar-vos en primícia que a partir del dimarts que ve ja no viuré sol. O sigui, que obro un nou cercle en la meva vida acompanyat de l’Estefania. Com a soferts lectors del meu blog haureu d’aguantar els comentaris que sovint es derivaran de la meva vida personal al costat d’aquesta persona tan especial per mi, ho sento per vosaltres però me n’alegro molt per mi 😉

Un cop fet aquest petit update a la meva vida i al meu silenci, una foto ben distesa d’una raqueta i una pilota de tenis gegants que hem vaig trobar pel carrer sortint d’un dinar familiar. Pels que no estigueu al corrent el tenis és un dels pocs hobbies no relacionats amb la tecnologia que hi ha a la meva vida i he de dir que malgrat sóc un paquet m’encanta jugar i ho passo genial.

Anant a temes més tècnics comentar que he hagut de canviar els dos estractors d’aire que tinc al petit-CPD de casa ja que s’havien fet malbé els motors que porten de tan donar voltes. N’he instal·lat un parell de nous i ara els he posat uns simples i ecònomics termostats de calefacció però en mode NC, d’aquesta manera malgrat són termostats de calefacció puc usar-los just amb la funció inversa. És a dir, mentre la temperatura ambient no baixa de una temperatura prefixada els estractors tenen corrent per funcionar, quan la temperatura baixa el termostat activa el relé i el que fa és tallar la corrent parant els motors. Comento això perquè fins ara jo només coneixia termostats que funcionaben en mode NO, o sigui, just alrevés del que he comentat. Però gràcies al Magí ara tinc aquest parell de termostats que funcionen la mar de bé, llàstima que hagin d’anar alimentats amb 2 piles AAA.

Comentar també que ahir vaig ser a l’oficina fins ben tard acompanyat de tres bons geeks: el Pof, l’Esteve i en Marc. Realment va ser una sessió molt constructiva sobre temes de cross-compiling per ARM9 una informació molt valuosa i que gràcies a l’Alfredo ben aviat serà una solució al problema que he tingut aquests mesos i que unes ratlles més amunt comentava.

Abans d’acabar no podia deixar de comentar que també vaig tenir l’oportunitat de jugar amb la HTC Diamondd que tan l’Esteve com en Pof ja tenen des d’ahir. Realment ha millorat molt aquesta HTC i ja es perfila com un ferma candidata a la meva pobre HTC Artemis que esta patint les més dures proves per ser el meu mòbil personal. No només vaig poder comprovar que el Diamond soluciona molt bé els problemes de velocitat que tenen els dispositius amb Windows Mobile sinó que l’accelerometre que incorpora és genial. En Pof també em va fer una demostració de tots els hacks que li ha fet la HTC Shift, a la que ja li ha canviat la ROM del Windows Mobile que incorpora i ha substituit el Windows Vista per una Ubuntu 8.04 que va com una seda, tota una delicia de dispositiu. La seva mida com a ultra-mobile PC esta molt bé, i si no fos pels inconvenients de no fer de telèfon malgrat tenir funcions de HDSPA i similars es consolidaria com un ferm candidat a substituir l’HTC Kaiser que em té aborrit amb la seva lentitut. Si la comparem amb un mòbil és molt gran, però és realment útil per treballar i que en el futur algún germanet seu espero que acabi sent la meva eina de treball de capçalera si no fos pel tema de no poder fer de telèfon ja ho seria aquesta però hauré d’esperar.